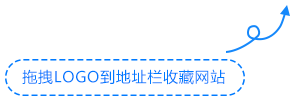

继美国 OpenAI 公司推出的 Sora 火出圈后,中国互联网科技巨头阿里巴巴在 2 月 28 日宣布推出了一款名为EMO的新型AI框架,官方称其为 ” 一种富有表现力的音频驱动的肖像视频生成框架 “。这项技术能够通过分析照片中的人物面部特征,生成逼真的动态效果,使得图片中的人物“开口说话”。

EMO框架的核心功能在于其卓越的面部识别和处理能力,它能够精确捕捉照片中人物的面部表情,并通过深度学习算法模拟出相应的口型和面部动作,能够无缝对接动态效果,最长可持续约1分30秒。无论语音内容、语速如何,或是图像风格怎样多变,EMO都能确保表情动作与声音完美匹配,使得每一个细节都显得格外到位。

EMO框架是基于英伟达的Audio2Video扩散模型构建的,使用了超过250小时的专业视频进行训练,因此能够创造出具有高度现实感和表现力的AI视频。

EMO框架的工作过程涉及两个关键阶段,首先是特征提取,然后是视频生成。

1、特征提取:在第一阶段,EMO利用一个称为ReferenceNet的网络从提供的参考图像和动作帧中提取特征。这一步骤是为了确保生成的视频能够保持角色身份的一致性。

2、视频生成:在第二阶段,预训练的音频编码器处理声音并将其嵌入,然后结合多帧噪声和面部区域掩码来生成视频。这个过程包括了对声音的分析以及相应的面部表情和口型的同步。

EMO框架的推出将对多个行业产生深远的影响。在娱乐行业,EMO可以用于制作更加生动的角色动画,提升观众的沉浸感;在教育领域,它可以帮助创建更具互动性的教学材料;在广告行业,EMO则能够为品牌营销带来全新的视觉体验。

总之,阿里巴巴推出的AI框架EMO在人工智能领域的深入研究和应用探索取得了新的突破,这不仅仅是一项技术创新,更是对未来人机交互方式的一次大胆预测。

-

广告合作

-

QQ群号:4114653