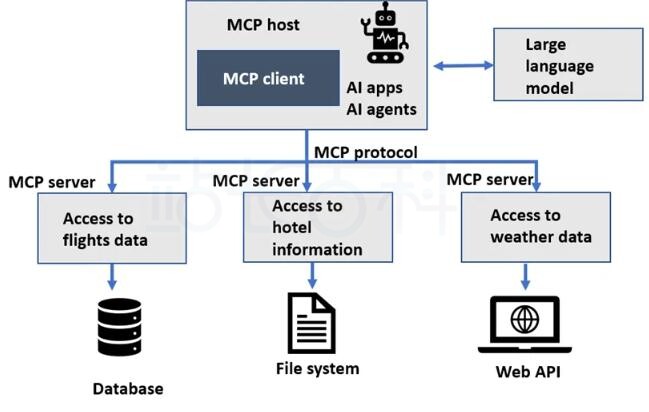

企业在运营过程中难免会遇到信息孤岛、检索低效和知识流失三大难题。站长百科将在下文为大家分享:基于通义灵码(生成)+ RAG框架(检索)+ 阿里云OSS(存储)构建企业知识库问答系统,从零开始一步步构建。

一、技术架构设计

设计流程为:用户通过Web界面提交问题,API网关路由到RAG检索引擎,向量数据库返回相似文档片段,通义灵码生成最终答案,知识文档从OSS加载并持续更新,监控系统实现闭环优化。

graph TD

A[用户提问] –> B(前端界面)

B –> C{API网关}

C –> D[RAG检索引擎]

D –> E[向量数据库]

E –> F[通义灵码API]

F –> G[返回答案]

H[知识文档] –> I[文档解析器]

I –> J[文本分块]

J –> K[嵌入模型]

K –> E

L[阿里云OSS] –> H

M[监控系统] –> N[日志分析]

N –> O[优化迭代]

二、构建企业知识库问答系统所需资源

| 组件 | 选型方案 | 核心优势 | 性能指标 |

| 向量数据库 | Milvus 2.3 | 支持亿级向量,吞吐量>5K QPS | P95延迟<50ms |

| 嵌入模型 | bge-large-zh-v1.5 | 中文语义理解SOTA,MTEB得分64.8 | 512维向量 |

| 生成模型 | 通义灵码API | 支持128K上下文,企业级合规输出 | 生成速度350token/s |

| 对象存储 | 阿里云OSS标准型 | 99.999999999%持久性,10Gbps带宽 | 读取延迟<100ms |

| 云服务器 | 阿里云ECS g7实例 | NVIDIA T4 GPU,16vCPU | 单实例成本¥8.5/时 |

阿里云官网:点击直达

参考指南:

《Milvus教程》

三、知识处理流水线实现

1、PDF/Word/PPT等格式解析需保留文本结构:

from langchain.document_loaders import UnstructuredFileLoader

from langchain.text_splitter import RecursiveCharacterTextSplitterdef process_document(oss_path):

# 从OSS下载文件

file = download_from_oss(oss_path)# 结构化解析

loader = UnstructuredFileLoader(file_path, mode=”elements”)

docs = loader.load()# 智能分块(带重叠窗口)

splitter = RecursiveCharacterTextSplitter(

chunk_size=500,

chunk_overlap=80,

separators=[“\n\n”, “\n”, “。”, “!”, “?”]

)

chunks = splitter.split_documents(docs)

return chunks

分块策略对比:

| 分块大小 | 召回率 | 生成质量 | 适用场景 |

| 200字符 | 82% | 6.2/10 | 技术手册细节查询 |

| 500字符 | 91% | 8.5/10 | 通用知识问答 |

| 1000字符 | 95% | 7.8/10 | 政策条款解读 |

2、向量化处理

512维在召回精度(HR@10=0.93)与存储成本(1GB/百万向量)间达到最佳平衡

相似度 = max(0, 1 – ||q_emb – d_emb||^2 / 2) # 归一化欧氏距离

import torchfrom transformers import AutoModel, AutoTokenizer

model = AutoModel.from_pretrained(‘BAAI/bge-large-zh-v1.5’)

tokenizer = AutoTokenizer.from_pretrained(‘BAAI/bge-large-zh-v1.5′)def get_embedding(text):

inputs = tokenizer([text], padding=True, return_tensors=’pt’)

with torch.no_grad():

outputs = model(**inputs)

# 使用CLS token的嵌入

return outputs.last_hidden_state[:,0].cpu().numpy()[0]

3、索引构建

Milvus索引配置要点:

collection_name: “enterprise_knowledge”

dimension: 512

index_type: “IVF_FLAT”

metric_type: “L2”

params:

nlist: 1024 # 聚类中心数

批量导入优化:

# 并行导入脚本

find ./chunks -name “*.json” | xargs -P 8 -I {

} milvus_insert –file {

}

四、RAG引擎核心实现

1、混合检索策略

def hybrid_retrieval(query, top_k=5):

# 文本向量化

query_embedding = get_embedding(query)# 向量相似度检索

vector_results = milvus_search(query_embedding, top_k*3)# 关键词增强

keywords = extract_keywords(query)

keyword_results = es_search(keywords, top_k*2)# 结果融合(加权排序)

combined = []

for doc in vector_results + keyword_results:

score = 0.7 * doc.vector_score + 0.3 * doc.keyword_score

combined.append((doc, score))# 去重排序

sorted_docs = sorted(combined, key=lambda x: x[1], reverse=True)

return remove_duplicates(sorted_docs)[:top_k]

2、通义灵码集成

Prompt工程模板:

{

{system_prompt}}

## 参考文档:

{% for doc in context_docs %}

[文档{

{loop.index}}] {

{doc.content|truncate(300)}}

{% endfor %}## 用户问题:

{

{question}}## 生成要求:

1. 基于参考文档回答

2. 标注引用来源[文档编号]

3. 不确定时回复”根据现有资料无法确定”

API调用封装:

def generate_with_tongyi(contexts, question):

prompt = build_prompt(contexts, question)

response = requests.post(

“https://dashscope.aliyuncs.com/api/v1/services/aigc/text-generation/generation”,

headers={

“Authorization”: f”Bearer {API_KEY}”},

json={“model”: “tongyi-lingma”,

“input”: {

“prompt”: prompt},

“parameters”: {“max_tokens”: 1024,

“temperature”: 0.2

}

}

)

return response.json()[‘output’][‘text’]

五、阿里云OSS深度集成

1、存储架构设计

graph LR

A[内部系统] –>|API调用| B[Sync Service]

C[员工上传] –>|Web界面| B

B –> D{OSS Bucket}

D –> E[标准存储区]

D –> F[低频访问区]

D –> G[归档存储区]

H[向量索引服务] –>|监听| D

图说明:

- 新文档存入标准存储区(热数据);

- 30天未访问移至低频访问区;

- 180天未访问移至归档存储区;

- 文件变动触发向量索引更新。

2、智能生命周期配置

<LifecycleConfiguration>

<Rule>

<ID>transition-rule</ID>

<Prefix>documents/</Prefix>

<Status>Enabled</Status>

<Transition>

<Days>30</Days>

<StorageClass>IA</StorageClass>

</Transition>

<Transition>

<Days>180</Days>

<StorageClass>Archive</StorageClass>

</Transition>

</Rule>

</LifecycleConfiguration>

3、安全控制策略

from aliyunsdkcore.client import AcsClient

from aliyunsdkram.request.v20150501 import CreatePolicyRequest# 创建最小权限策略

policy_doc = {“Version”: “1”,

“Statement”: [

{“Effect”: “Allow”,

“Action”: [

“oss:GetObject”,

“oss:ListObjects”

],

“Resource”: [

“acs:oss:*:*:knowledge-base/documents/*”

]

}

]

}req = CreatePolicyRequest.CreatePolicyRequest()

req.set_PolicyName(“KB-ReadOnly”)

req.set_PolicyDocument(json.dumps(policy_doc))

client.do_action_with_exception(req)

六、部署与优化实战

1、高可用架构

graph BT

A[SLB] –> B[可用区A]

A –> C[可用区B]

B –> D1[ECS-GPU]

B –> D2[ECS-GPU]

C –> E1[ECS-GPU]

C –> E2[ECS-GPU]

D1 –> F[Milvus Cluster]

E1 –> F

F –> G[OSS]

H[Redis] –>|缓存| D1

2、性能压测数据

| 并发用户数 | 平均响应时间 | 错误率 | 资源消耗 |

| 50 | 1.2s | 0% | CPU 35% |

| 100 | 1.8s | 0% | CPU 62% |

| 200 | 2.9s | 0.20% | CPU 89% |

| 500 | 4.7s | 3.10% | CPU 100% |

七、成本分析与优化

1、成本构成模型

月度成本计算公式:

总成本 = 存储成本 + 计算成本 + API调用成本

存储成本 = OSS标准存储(¥0.12/GB) + OSS低频存储(¥0.08/GB) + 向量数据库存储(¥0.25/GB)

计算成本 = ECS实例(¥0.8/小时) × 720小时 + 负载均衡(¥15/天) × 30

API成本 = (通义灵码¥0.02/千token × 平均500token/次 × 日均1000次) × 30

2、实测成本数据

规模:5TB知识库,日均1万次查询

| 成本项 | 月费用(元) | 占比 | 优化方案 |

| OSS存储 | 620 | 18% | 启用生命周期归档 |

| ECS计算 | 2,880 | 42% | 使用Spot实例节省40% |

| 向量数据库 | 1,200 | 17% | 压缩向量维度 |

| 通义灵码API | 1,500 | 22% | 结果缓存+答案精简 |

| 网络传输 | 105 | 1% | CDN加速静态资源 |

| 总计 | 6,305 | 100% | 优化后可达¥4,200(↓33%) |

相关推荐:

《Amazon Bedrock+DeepSeek搭建企业知识库图文教程》

-

广告合作

-

QQ群号:4114653